Perché Apple ha appena comprato una start-up israeliana che legge le micro-espressioni del volto

Apple ha messo a segno una delle acquisizioni più importanti della sua storia recente, rilevando la start-up israeliana Q.ai per una cifra stimata intorno ai due miliardi di dollari. A fare gola all'azienda di Cupertino è una nuova tecnologia che integra l'intelligenza artificiale per migliorare le prestazioni dei dispositivi sfruttando le espressioni facciali, anche quelle pressoché invisibili all'occhio umano

Come sottolineato dal Financial Times, si tratta della seconda operazione più costosa mai realizzata da Apple dopo i tre miliardi di dollari spesi per inglobare la Beats nel 2014. Un passaggio che evidenzia come questa volta la posta in gioco non sia un singolo prodotto, ma una visione più ampia dell'IA e delle interfacce del futuro. Un futuro forse più smart e inclusivo, ma in cui potrebbe bastare uno sguardo per rivelare a una macchina molto più di quanto si vorrebbe.

Cos'è Q.ai e perché è strategica

Fondata a Tel Aviv nel 2022, Q.ai ha operato finora lontano dai riflettori, sviluppando una tecnologia capace di interpretare il cosiddetto silent speech, ossia una forma di comunicazione che si basa su micro-movimenti del volto e della pelle del viso che possono essere tradotti in comandi e intenzioni senza l'uso della voce o di altri input. Si tratta dunque di un sistema che combina visione artificiale, sensori ottici e meccanismi di machine learning, pensato per funzionare in modo continuo, discreto e privato, soprattutto su dispositivi indossabili.

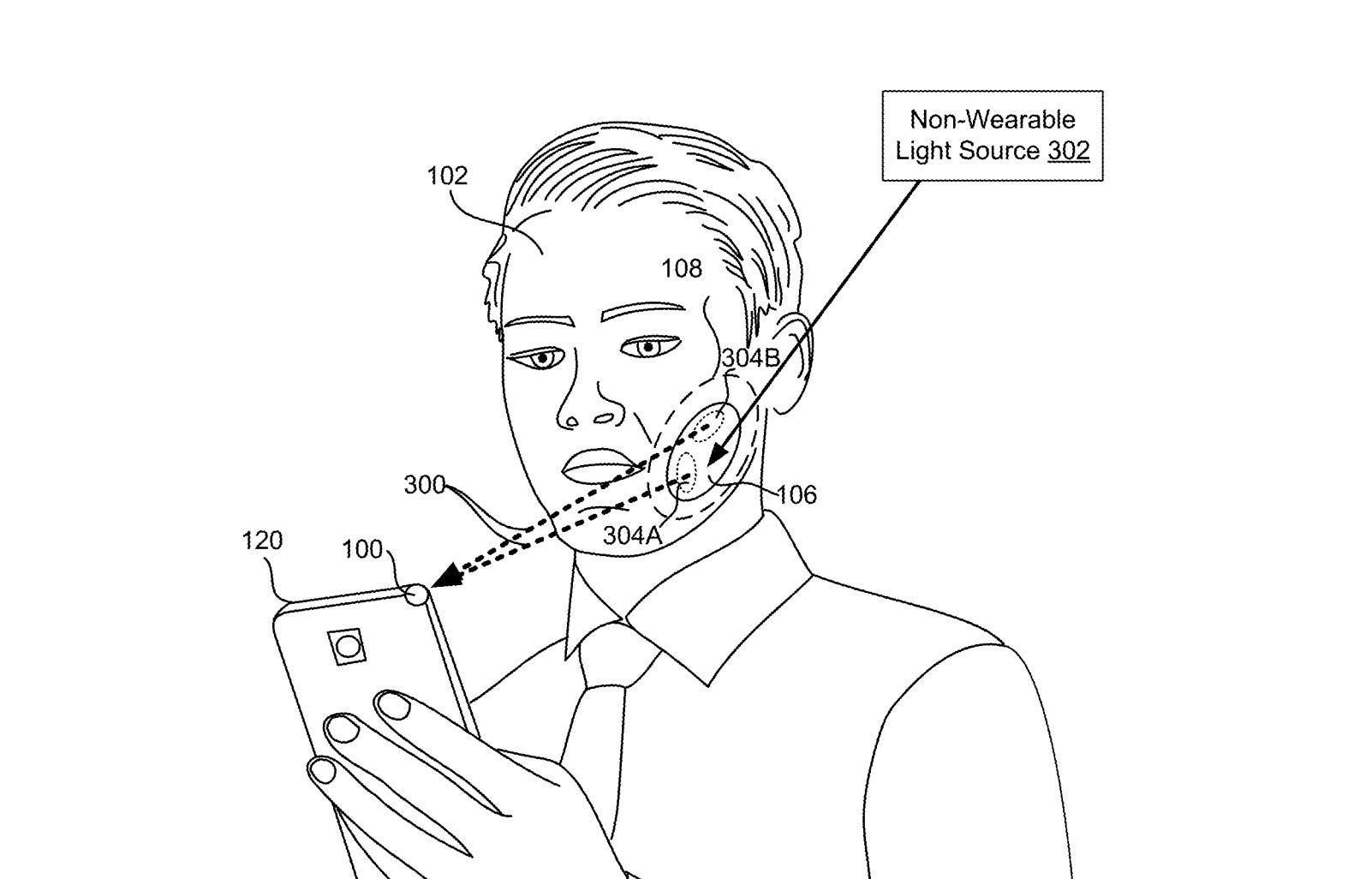

Il brevetto depositato da Q.ai descrive infatti un insieme di soluzioni che rilevano e interpretano micro-movimenti di labbra, mascella e muscoli facciali, senza la necessità di aggiungere comandi vocali per attivare la funzione desiderata. I dati possono essere elaborati localmente, riducendo problemi di latenza e privacy, e restituiscono risposte pensate per restare personali e invisibili agli altri. Non si tratta pertanto di un semplice miglioramento di un assistente vocale, ma di una possibile ridefinizione dell'interazione uomo-macchina.

L'idea di fondo risiede nel fatto che parlare con un'AI non è sempre possibile né desiderabile. In ambienti rumorosi, contesti pubblici o situazioni che richiedono riservatezza, l'utilizzo della voce può essere un limite. Il volto, invece, è sempre attivo e comunicativo, a patto ovviamente di avere i giusti strumenti per interpretarlo.

I fondatori e le intenzioni di Apple

Alla guida di Q.ai c'è Aviad Maizels, imprenditore israeliano già noto ad Apple per aver fondato PrimeSense, la società la cui tecnologia di rilevamento 3D è alla base di Face ID, la funzione che sblocca gli IPhone con il volto. Con lui entrano in Apple anche i co-fondatori Yonatan Wexler e Avi Barliya.

Wexler è uno scienziato della computer vision con esperienze a Oxford, al Weizmann Institute e in Microsoft. Negli ultimi anni ha lavorato in OrCam, sviluppando dispositivi di supporto per persone cieche e ipovedenti, basati su riconoscimento di immagini e testi. Barliya è invece un imprenditore seriale, con progetti che spaziano dalla guida autonoma alle missioni spaziali lunari con SpaceIL, l'organizzazione israeliana che punta a far atterrare il primo lander privato sulla Luna.

I tre hanno dato vita a una tecnologia che, secondo indiscrezioni e documenti brevettuali, potrebbe trovare applicazione in tutti i prodotti di punta di casa Apple (AirPods, smart glasses, Vision Pro, iPhone e Mac), alimentando una nuova generazione di Siri potenziata dall'IA generativa. Lo scopo sarebbe rendere l'interazione con il devie sempre più diretta e priva di barriere, in un momento in cui Apple cerca di recuperare terreno rispetto a Meta, Google e OpenAI nel campo dei dispositivi smart indossabili.

Inclusione e il tema della sorveglianza invisibile

Le prospettive aperte da questa tecnologia appaiono significative anche sul piano dell'inclusione. La possibilità di utilizzare interfacce che non richiedono voce, mani libere o gesti evidenti può rappresentare un enorme passo avanti per persone con disabilità motorie, sensoriali o del linguaggio. Allo stesso tempo, però, la direzione intrapresa delle Big Tech è chiara e pone interrogativi seri.

Un mondo in cui ogni respiro, ogni battito di ciglia, ogni micro-espressione può essere letta da una macchina è anche un sistema in cui il confine tra supporto e sorveglianza diventa sottile. L'AI osserva in silenzio, promette comodità e accessibilità, ma alimenta sistemi che si nutrono di dati sempre più intimi e personali. Un aspetto per nulla secondario in una società dove le informazioni, anche quelle apparentemente più insignificanti, sono la nuova moneta per orientare i mercati e le stesse strategie politiche. Cosa può riservare un futuro dove governi e colossi digitali riescono a interpretare le intenzioni di un individuo semplicemente misurando il suo respiro o analizzando i micro-movimenti della sua pelle? La sfida per l'umanità di domani probabilmente si giocherà proprio qui e l'esito della partita appare quanto mai incerto.